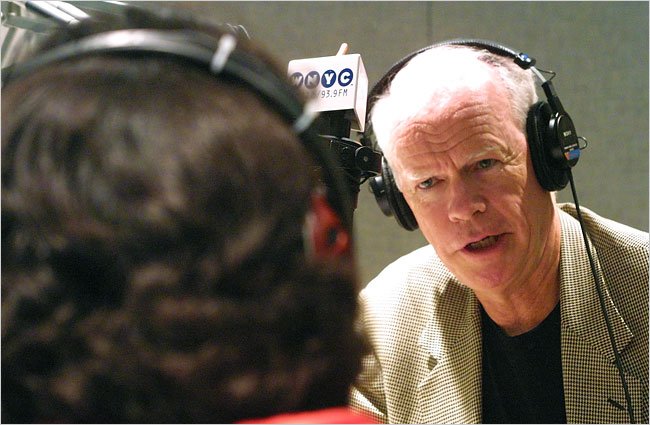

Por la muerte del periodista e icono cultural norteamericano Tom Wolfe a sus 88 años, La Cebra que Habla presenta este texto sobre divulgación científica del reconocido autor. En pocas palabras, un hombre que marcó una generación de periodistas, creó escuela con sus artículos y triunfó con ‘La hoguera de las vanidadades’. Bienvenidos.

Por: Tom Wolfe

Texto extraído de Alcoberro.Info

Como no estoy del todo a la última, me enteré de la revolución digital en febrero del año pasado, cuando Louis Rossetto, cofundador de la revista Wired, vestido con una camisa sin cuello, con el pelo tan largo como Felix Mendelssohn y todo el aspecto de un visionario californiano, dio una conferencia en el Instituto Caton anunciando el alba de la civilización digital del siglo XXI.

Como tema, eligió a Pierre Teihard de Chardin, el inconformista científico y filósofo jesuita que profetizó hace cincuenta años que la radio, la televisión y los ordenadores crearían una «noosfera», una membrana electrónica que cubriría el globo y conectaría a toda la humanidad en un único sistema nervioso.

Que la geografía, las fronteras nacionales o las viejas nociones de mercado y procesos políticos se volverían irrelevantes. Según Rossetto, la vertiginosa expansión de Internet por todo el planeta hace que, gracias al módem, ese maravilloso momento esté casi al alcance de la mano. Podría ser. Sin embargo, algo me dice que hacia el 2006, todo el universo digital va a parecernos bastante trivial en comparación con la nueva tecnología que ahora mismo es sólo un tenue resplandor en un minúsculo número de hospitales estadounidenses y cubanos (sí, cubanos). Son las técnicas de obtención de imágenes cerebrales, y cuantos se atrevan a madrugar y contemplar un amanecer verdaderamente deslumbrante del siglo XXI no desearán apartar la vista.

Las técnicas de obtención de imágenes cerebrales persiguen observar el cerebro humano en funcionamiento, en tiempo real. En la actualidad, las formas más avanzadas son la electroencefalografía tridimensional basada en modelos matemáticos; la más familiar tomografía de emisión de positrones (TEP); las nuevas técnicas de la resonancia magnética funcional, que muestra los patrones del flujo sanguíneo cerebral, y de la espectroscopia por resonancia magnética, que mide los cambios bioquímicos del cerebro; y la aún más nueva TEP identificadora de genes/TEP identificadora de marcadores, tan nueva que todavía no le han encontrado un nombre más sencillo.

Utilizada hasta ahora sólo en animales y en un reducido número de niños gravísimamente enfermos, la TEP identificadora de genes/TEP identificadora de marcadores localiza y sigue la actividad de genes específicos. En la pantalla del escáner se ve como se encienden dentro del cerebro los genes en cuestión. Según los parámetros de 1996, son instrumentos sofisticados. Dentro de diez años tal vez parezcan rudimentarios en comparación con las sorprendentes nuevas ventanas que puedan haberse abierto en el cerebro.

Las técnicas de obtención de imágenes cerebrales se inventaron para facilitar la diagnosis médica; sin embargo lo que resulta mucho más importante es que quizá confirmen de un modo irrefutable ciertas teorías sobre la «mente», el «yo», el «alma» y el «libre albedrío» en las que ya creen con devoción los científicos de lo que en la actualidad es el ámbito más efervescente del mundo académico, la neurociencia. Por supuesto, todas esas comillas bastan para poner en guardia a cualquiera, pero el Escepticismo Supremo forma parte del fulgor de ese amanecer que he prometido.

La neurociencia, la ciencia del cerebro y el sistema nervioso central, se encuentra en el umbral de una teoría unificada cuyas repercusiones serán tan espectaculares como las del darwinismo hace cien años. Ya existe un nuevo Darwin o quizá debería decir un Darwin actualizado, puesto que nadie ha creído más religiosamente que él en Darwin. Se llama Edward O. Wilson. Enseña zoología en Harvard y es autor de dos libros que han tenido una influencia extraordinaria THE INSECT SOCIETIES y SOCIOBIOLOGÍA: LA NUEVA SÍNTESIS.

No «una» nueva síntesis, sino «la» nueva síntesis; y si tenemos en cuenta la talla de Wilson en el terreno de la neurociencia, no se trata de una fanfarronada. Edward O. Wilson ha creado y dado nombre a la nueva disciplina de la sociobiología y ha condensado su premisa subyacente en una única frase. Todo cerebro humano, afirma, no nace siendo una tabla rasa que la experiencia se encarga de rellenar, sino que es «un negativo expuesto a la espera de ser introducido en el líquido revelador».

El negativo puede revelarse bien o puede revelarse de modo defectuoso, pero en cualquiera de los dos casos poco se obtendrá que no esté ya impreso en la película. Esa impresión es la historia genética del individuo, producto de miles de años de evolución, y nadie puede hacer gran cosa para alterar ese hecho.

Es más, según Wilson, la genética determina no sólo cosas como el temperamento, las preferencias en los roles, las respuestas emocionales y los niveles de agresión, también muchas de nuestras reverenciadas elecciones morales, que en absoluto son elecciones en un sentido que implique libre albedrío, sino más bien tendencias impresas en el hipotálamo y las regiones límbicas del cerebro, una noción ampliada en 1993 por James Q. Wilson (sin parentesco con Edward O.) en THE MORAL SENSE, un libro que dio mucho que hablar.

Esta visión, la visión neurocientífica de la vida, se ha convertido en el campo de batalla estratégico del mundo académico, y la ofensiva para conquistarlo ya se ha extendido más allá de las disciplinas científicas y se ha adentrado en el ámbito del público en general. Tanto progresistas como conservadores sin un ápice de voluntad científica se afanan por ocupar ese terreno. El movimiento homosexual, por ejemplo, se ha aferrado a un estudio del respetado Dean Hamer, de los Institutos Nacionales de la Salud, en el que se anunciaba el descubrimiento del «gen homosexual».

Es evidente que si la homosexualidad resulta ser un rasgo determinado por la genética, igual que el hecho de ser zurdo o de tener los ojos castaños, las leyes y las sanciones que la penalizan constituyen intentos de legislar contra la naturaleza. Los conservadores, en cambio, se han centrado en estudios que indican que, como consecuencia del largo trayecto de la evolución, los cerebros de hombres y mujeres están organizados de modo tan dispar que los intentos feministas de permitir a las mujeres el acceso a papeles tradicionalmente reservados a los hombres se reducen a lo mismo: una transgresión de la naturaleza condenada al fracaso. En esta cuestión, el propio Wilson se ha visto salpicado; bueno, en realidad, algo más que salpicado.

Pienso que Wilson es lo que en Estados Unidos se considera un liberal convencional, políticamente correcto, como se dice –al fin y al cabo pertenece a Harvard–, alguien preocupado por los problemas medioambientales y todas esas cosas. Sin embargo, ha afirmado que «imponer identidades de roles similares» a hombres y mujeres es algo que «hace caso omiso de miles de años en los que los mamíferos han demostrado una poderosa tendencia a la división sexual del trabajo».

El hecho de que esta división del trabajo sea una constante desde las sociedades cazadoras recolectoras pasando por las agrícolas hasta las industriales sugiere un origen genético. No sabemos en qué momento de la evolución humana se desarrolló este rasgo ni cuán resistente es a las continuas y justificadas presiones a favor de los derechos humanos». En «resistente» habla Darwin II, el neurocientífico; en «justificadas», el liberal políticamente correcto de Harvard. No fue lo bastante liberal ni lo bastante políticamente correcto.

Un grupo de manifestantes feministas interrumpieron una de sus conferencias, le lanzaron encima un cubo de agua helada y empezaron a corear: «¡Se ha mojado encima!, ¡Se ha mojado encima» La más destacada de las feministas estadounidenses; Gloria Steinem, insistió en una entrevista televisiva con John Stossel, de la ABC, en que había que frenar de inmediato los estudios sobre las diferencias genéticas de los sistemas nerviosos masculino y femenino. Sin embargo, todo esto no fue en nada en comparación con el pánico político desatado en relación con la neurociencia.

En febrero de 1992, Frederik K. Goodwin, reputado psiquiatra y director de la Administración de Salud Mental, Drogadicción y Alcoholismo, pero un perfecto inepto en relaciones públicas, cometió el error de describir en una reunión pública la Iniciativa contra la Violencia del Instituto Nacional de la Salud Mental.

Se trataba de un programa experimental, que ya tenía diez años, cuya hipótesis era que, como entre los monos de la selva –Goodwin era famoso por sus estudios con monos–, la mayor parte de la criminalidad estadounidense estaba causada por unos pocos machos jóvenes predispuestos genéticamente; es decir, programados para cometer delitos.

En la jungla, entre los parientes más próximos de los seres humanos, los chimpancés, parecía como si un puñado de jóvenes machos con cierta distorsión genética fueran los responsables de casi todas las muertes innecesarias de otros machos y el maltrato físico de las hembras. ¿Y si ocurría lo mismo entre los seres humanos? ¿Y si, en cualquier comunidad, resultaba que un puñado de muchachos con un ADN tóxico era el responsable del elevado número de delitos violentos? La Iniciativa contra la Violencia pretendía identificar a esos individuos en la infancia para, de algún modo, algún día, someterlos a una terapia farmacológica.

Foto extraída de: The New York Times

Según dijo Goodwin, la idea de que las zonas urbanas de Estados Unidos castigadas por el crimen eran una «jungla» podía ser algo más que una metáfora gastada. Eso la armó. Quizá fue ésa la palabra más estúpida pronunciada por un funcionario público estadounidense en todo 1992. El clamor fue inmediato.

El senador Edward Kennedy de Massachusetts y el congresista John Dingell de Michigan (quien, como más tarde se hizo patente, padecía hidrofobia ante los proyectos científicos) no sólo condenaron por racistas las observaciones de Goodwin, sino que también emitieron su veredicto científico: las investigaciones con primates son «una base ridícula» para analizar algo tan complejo como «el crimen y la violencia que asola hoy nuestro país».

(Lo cual constituyó una sorpresa para los científicos de la NASA que primero entrenaron y enviaron en vuelo suborbital con un cohete Redstone a un chimpancé llamado Ham y luego entrenaron y enviaron a otro llamado Enos, «hombre» en griego, a que orbitara la Tierra en un cohete Atlas, con lo que predijeron las respuestas fisiológicas, psicológicas y motrices de los astronautas humanos, Alan Shepard y John Glenn, quienes repitieron, meses más tarde, los vuelos y las tareas de los chimpancés.) La Iniciativa contra la Violencia fue comparada a las propuestas eugenésicas nazis para la exterminación de los indeseables.

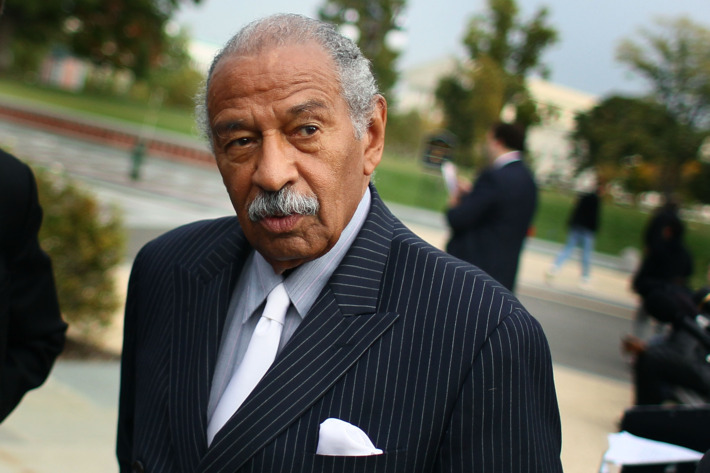

El congresista John Conyers, también de Michigan al igual que Dingell, presidente del Comité de Operaciones del Gobierno y miembro más antiguo del Caucus Negro del Congreso, pidió la renuncia de Goodwin, renuncia que obtuvo, al cabo de dos días, tras lo cual el gobierno, a través del Departamento de Salud y Servicios Humanos, negó que la iniciativa contra la violencia hubiese existido nunca. Desapareció en el agujero de la memoria, para utilizar la expresión de Orwell.

Para Mayo de 1993 se había previsto un congreso de criminólogos y otros académicos interesados en los estudios neurocientíficos realizados hasta entonces para la Iniciativa contra la Violencia, un congreso financiado, en parte, por los Institutos Nacionales de la Salud.

Adiós también al congreso; los INS lo ahogaron como un gatito. En 1995 un experto legal de la Universidad de Maryland intentó reunir las tropas subrepticiamente, en un recinto casi oculto de los ojos de los hombres, en un pequeño pueblo llamado Queenstown en los remotos confines del condado de Queen Annes, en la costa oriental de Maryland.

Los INS, demostrando que son de aprendizaje lento, concedieron discretamente 133.000 dólares para la reunión después de que Wasserman prometiera suavizar el encuentro invitando a detractores de la idea de un posible origen genético del crimen y organizar una sesión sobre los males del movimiento eugenésico de principios del siglo XX.

¡En vano! Un ejército de manifestantes descubrió a aquellos pobres desgraciados e irrumpió en el escenario gritando: «¡Congreso de Maryland no te escondas, sabemos que fomentas el genocidio!» Tardaron dos horas en aburrirse y marcharse y el congreso finalizó en un estado de completa confusión, con un comunicado de la facción políticamente correcta especialmente invitada que decía: «Tanto científicos como historiadores y sociólogos deben impedir ser utilizados para revestir de respetabilidad científica a la pseudociencia racista». Hoy en los INS la expresión Iniciativa contra la violencia es sinónimo de tabú.

El momento actual recuerda la Edad Media, cuando la Iglesia católica prohibió la disección de cuerpos humanos por temor a que lo que pudiera descubrirse dentro de ellos arrojara alguna duda sobre la doctrina cristiana de que Dios había creado el hombre a su semejanza. Aún más radioactivo es el tema de la inteligencia, tal como la miden las pruebas de inteligencia.

En privado –no son muchos los que se atreven a hablar en público– la abrumadora mayoría de los neurocientíficos cree que el componente genético de la inteligencia de un individuo es notablemente elevado. La inteligencia de una persona puede mejorarse gracias a tutores hábiles y entregados o puede frenarse por culpa de una educación deficiente –esto es, el negativo se revela bien o de modo defectuoso–, pero lo fundamental son sus genes.

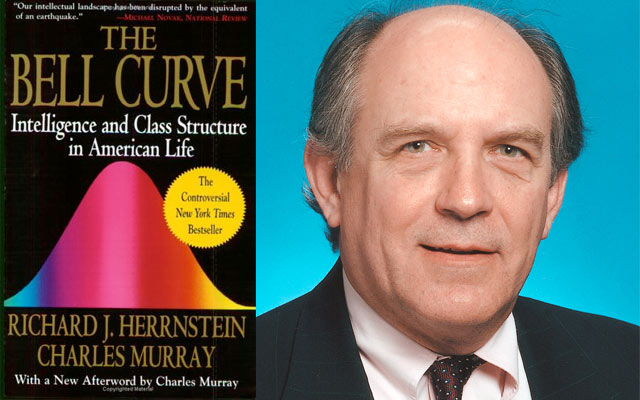

El reciente alboroto provocado por el libro de Charles Murray y Richard Hernstein THE BELL CURVE es seguramente sólo el principio del enconamiento que el tema va a producir. No hace mucho, según dos neurocientíficos a los que entrevisté, una compañía llamada Neurometrics buscó inversores e intento comercializar un invento simple, pero sorprendente, bautizado con el nombre de «casco de inteligencia».

La idea era encontrar un modo de medir la inteligencia que no tuviera rasgo de «sesgo cultural», un medio que no obligase a nadie a enfrentarse con palabras o conceptos que podrían ser conocidos por personas de una cultura pero no por las de otras.

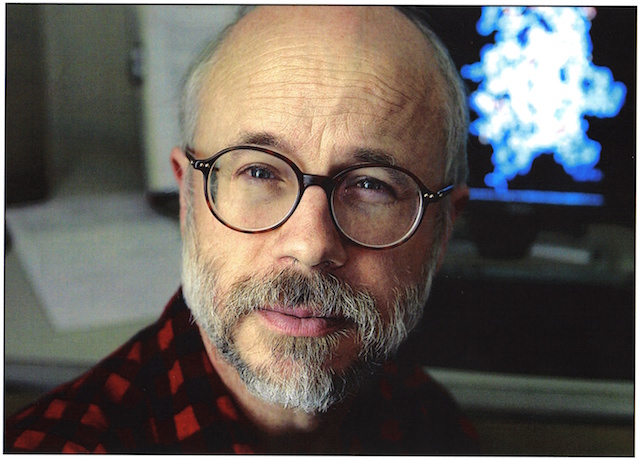

El casco de inteligencia registraba sólo ondas cerebrales; y un ordenador, no un ser humano sujeto a posibles distorsiones analizaba los resultados. Estaba basado en la obra de neurocientíficos como E. Roy John [1], quien es hoy uno de los principales pioneros de la obtención de imágenes electroencefalográficas del cerebro.

Dulio Giannitrapani, autor de THE ELECTROPHYSIOLOGY OF INTELLECTUAL FUNCTIONS y David Robinson, autor de THE WECHSLER ADULTS INTELLIGENCE SCALE AND PERSONALITY ASSESSMENT: TOWARD A BIOLOGICALLY BASED THEORY OF INTELLIGENCE AND COGNITION y muchas otras monografías famosas entre los neurocientíficos.

Hablé con un investigador que había diseñado un casco de inteligencia replicando un experimento descrito por Giannitrapani en THE ELECTROPHYSIOLOGY OF INTELLECTUAL FUNCTIONS. No era un proceso complicado. Se colocaban dieciséis electrodos en la cabeza de la persona cuya inteligencia quería medirse. Había que despeinarla un poco, pero no era necesario cortar el pelo y menos aún raparlo. A continuación se le decía que mirara un punto fijo. El investigador con el que hablé utilizaba una chincheta roja. Se accionaba el interruptor y, en dieciséis segundos, el ordenador daba una predicción precisa (con un máximo de medio punto de desviación estándar) de lo que el sujeto obtendría en los once subtests del Wechsler Adult Intelligence Scale (WAIS) o, en el caso de niños, en el Wechsler Intelligence Scale for Children (WISC); todo en dieciséis segundos de ondas cerebrales.

El test no tenía ni un atisbo de influencia cultural. ¿Qué tiene de cultural mirar una chincheta clavada en la pared? El ahorro en tiempo y dinero era espectacular. Se tarda dos horas en pasar el test de inteligencia convencional; y los gastos generales, contando las personas encargadas de pasarlo, prepararlo, así como el pago del alquiler de los locales, ascienden como mínimo, a 100 dólares la hora.

Para el casco de inteligencia eran necesarios quince minutos y dieciséis segundos –el cuarto de hora es lo que se tarda en colocar los electrodos- y una décima parte de un centavo en electricidad.

Los inversores de Neurometrics se frotaban las manos y ser relamían. Iban a forrarse. Lo que en realidad ocurrió fue que nadie se interesó por ese diabólico casco. No fue sencillamente que nadie creyera que pudieran extraerse cocientes de inteligencia a partir de las ondas cerebrales, fue que nadie quiso creer que pudiera hacerse. Nadie quiso creer que la capacidad cerebral humana está hasta tal punto… programada.

Nadie quiso creer que era… una mediocridad genéticamente programada… y que lo mejor a lo que podía esperar en este Pozo del Error Mortal era a vivir su mediocre vida gris sin demasiado estrés.

Barry Sterman, de la UCLA, y director científico de una compañía llamada Cognitive Neuroscience, diseñador de una tecnología que aplica las ondas cerebrales a la investigación de mercados y los grupos de interés, considera posibles las pruebas de inteligencia por medio de las ondas cerebrales, pero en la actual atmósfera «tiene menos posibilidades que un chino de conseguir una subvención» para desarrollarlas.

Y aquí comenzamos a sentir el frío que emana del ámbito más efervescente del mundo académico. La premisa implícita y en gran medida inconsciente de la lucha por el estratégico terreno de la neurociencia es: vivimos en una época en que la ciencia es un tribunal que no tiene apelación.

Y la cuestión esta vez, a finales del siglo XX, no es ya la evolución de las especies, que puede parecer un asunto muy remoto, sino la naturaleza de nuestros apreciados “yos” interiores. Los patriarcas de la disciplina, como Wilson, son conscientes de ello y se muestran cautos, cautos en comparación con la nueva generación.

Wilson aún sostiene la posibilidad –creo que duda, pero a pesar de todo sigue sosteniendo la posibilidad– de que, en algún punto de la historia evolutiva, la cultura empezara a influir en el desarrollo del cerebro humano en formas aún no completamente explicadas por la teoría darwinista estricta. Sin embargo, los neurocientíficos de la nueva generación no son, ni de lejos, tan cautos.

En conversaciones privadas, las charlas que crean la atmósfera mental de cualquier nueva ciencia en auge –y me encanta hablar con ellos– expresan un determinismo inflexible. Empiezan con la afirmación más famosa de toda la filosofía moderna, el «cogito ergo sum» de Descartes que consideran como la esencia del «dualismo», esa anticuada noción de que la mente es algo distinto de su maquinaria, el cerebro y el cuerpo.

(Un poco más abajo haré referencia a la segunda afirmación más famosa). También se la conoce como la falacia «del fantasma dentro de la máquina», la singular creencia de que en algún lugar dentro del cerebro existe un «yo» fantasmal que interpreta y dirige sus operaciones.

Los neurocientíficos que se dedican a la encefalografía tridimensional afirman con claridad que no hay ningún lugar en el cerebro que sea la sede de la conciencia o de la autoconciencia (cogito ergo sum). Se trata de una mera ilusión creada por una combinación de sistemas neurológicos que actúan al mismo tiempo. La joven generación da incluso otro paso más.

Puesto que la conciencia y el pensamiento son productos enteramente físicos de nuestro cerebro y nuestro sistema nervioso –y puesto que nuestro cerebro ya ha nacido impreso– ¿qué nos hace pensar que tenemos libre albedrío? ¿De dónde provendría? ¿Qué «fantasma», qué «mente», qué «yo», qué «alma», qué lo que sea que no resulte que no resulte inmediatamente atrapado por esas comillas despectivas, es lo que hincha nuestro tronco cerebral y se nos ofrece?

He oído que los neurocientíficos teorizan sobre la posibilidad de que, de tener ordenadores lo bastante potentes y sofisticados, sería posible predecir el curso de la vida de cualquier ser humano momento a momento, incluyendo el hecho de que el pobre diablo fuera a sacudir la cabeza ante esa misma idea.

Dudo de que cualquier calvinista del siglo XVI creyera de un modo tan completo en la predestinación como estos efervescentes e intensamente racionales jóvenes científicos estadounidenses de finales del siglo XX. Desde finales de los setenta, en la Era de Wilson, los estudiantes universitarios no cesan de acercarse a la neurociencia. La Sociedad para la Neurociencia se fundó en 1970 con 1.100 miembros. Hoy, una generación más tarde, sus miembros superan los 26.000. La última convención de esta Sociedad, en San Diego, reunió a 23.052 almas, con lo que se convirtió en una de las mayores convenciones profesionales del país.

En el venerable campo de la filosofía académica, los jóvenes miembros del profesorado están desertando en número que resulta embarazoso y se pasan a la neurociencia. Van camino de los laboratorios. ¿Qué sentido tiene luchar con el Dios, la Libertad y la Inmortalidad de Kant si es sólo una cuestión de tiempo que la neurociencia es posible que gracias a las técnicas de obtención de imágenes cerebrales, revele la auténtica maquinaria física que envía esos constructos mentales, esas ilusiones, sinapsis tras sinapsis, hasta las áreas de Broca o de Wernicke del cerebro? Lo cual nos lleva a la segunda afirmación más famosa de toda la filosofía moderna el «Dios ha muerto» de Nietzsche. Se formuló en el año 1882 (en el libro EL GAY SABER.) Nietzsche no la hizo como declaración de ateísmo, por más que en realidad él fuera ateo, sino sencillamente como comunicación de un acontecimiento.

Consideró que la muerte de Dios era «el más grande de los últimos acontecimientos», el mayor acontecimiento de la historia moderna. La noticia era que como consecuencia del aumento del racionalismo y el pensamiento científico, incluyendo el darwinismo, en relación con los últimos 250 años anteriores, las personas cultas ya no creían en Dios. Sin embargo, antes de que los ateos levantéis vuestras banderas triunfales, afirmó, pensad en las implicaciones. «La historia que tengo que contar es la historia de los próximos dos siglos», escribió Nietzsche. Predijo (en ECCE HOMO) que el siglo XX sería un siglo de «guerras como nunca han ocurrido en la Tierra», guerras catastróficas más allá de todo lo imaginable. ¿Y por qué? Porque los seres humanos ya no tendrían un dios hacia quien volverse, que los absuelva de su culpa; seguirán atormentados por la culpa, puesto que la culpa es un impulso inculcado en los niños desde muy pequeños, antes de la edad de la razón.

El resultado será que las personas no sólo aborrecerán a los demás, sino que también se aborrecerán a sí mismas. La ciega y tranquilizadora fe que antes habían dedicado a la creencia en Dios, dijo Nietzsche, la dedicarían entonces a la creencia en bárbaras hermandades nacionalistas: «Si las doctrinas… de ausencia de toda distinción cardinal entre el hombre y el animal, doctrinas que considero verdaderas pero mortales –afirma aludiendo al darwinismo en MEDITACIONES INTEMPESTIVAS- son arrojadas a la gente durante otra generación… que nadie se sorprenda cuando… en el futuro aparezcan en escena… hermandades cuyo objetivo sea el robo y la explotación de los no hermanos».

La idea de Nietzsche de la culpa es también un siglo más tarde la de los neurocientíficos, que consideran la culpa como una de esas tendencias impresas en el cerebro en el momento del nacimiento. En algunas personas, la obra genética no está completa, y se lanzan a un comportamiento criminal sin un ápice de remordimiento, intrigando con ello a los criminólogos que quieren crear Iniciativas contra la Violencia y celebrar congresos sobre el tema.

Nietzsche dijo que la humanidad atravesaría el siglo «en la miseria» de la descomposición de los códigos morales inspirados por Dios y que luego, en el siglo XXI, llegaría un período más tenebroso aún que el de las grandes guerras, una época de «eclipse total de todos los valores» (en LA VOLUNTAD DE PODER).

Se trataría también de un período frenético de «revaloración», en que la gente intentaría encontrar nuevos valores para sustituir a los osteoporóticos esqueletos de los viejos sistemas. Sin embargo, advirtió, fracasaréis porque no podéis creer en códigos morales sin creer al mismo tiempo en un dios que os señale con su temible dedo y diga lo que está bien y lo que está mal. ¿Por qué debe preocuparnos una espeluznante predicción que parece tan inverosímil como el «eclipse total de todos los valores»? A causa, precisamente de los antecedentes del hombre, diría yo. Al fin y al cabo, en Europa, en la pacífica década de 1880, debió de resultar aún más inverosímil predecir las guerras mundiales del siglo XX y las bárbaras hermandades del nazismo y el comunismo. “Ecce vates. Ecce vates”.

He aquí al profeta. ¿Qué más cabe pedir como prueba de los poderes de predicción de un hombre? Hace un siglo, quienes se preocupaban por la muerte de Dios podían consolarse con el hecho de seguir teniendo su propio yo resplandeciente y su alma inviolable como asidero moral, así como las maravillas de la ciencia moderna para encontrar su camino.

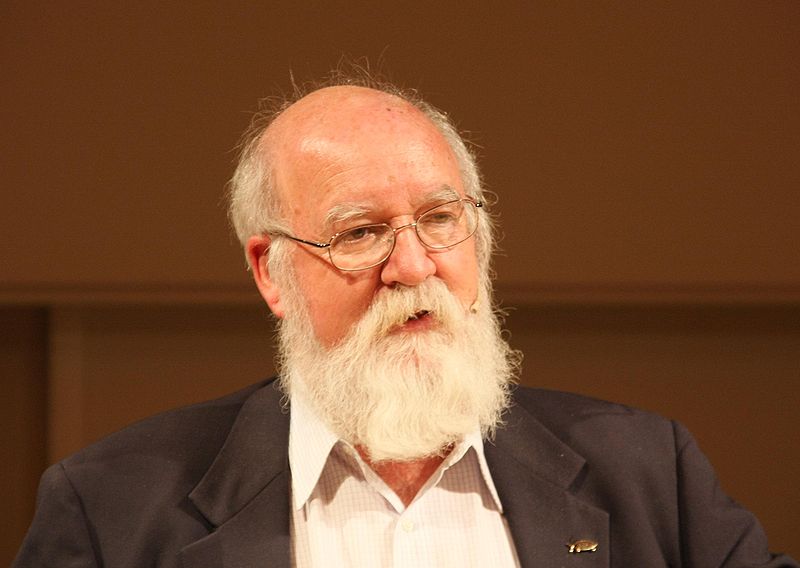

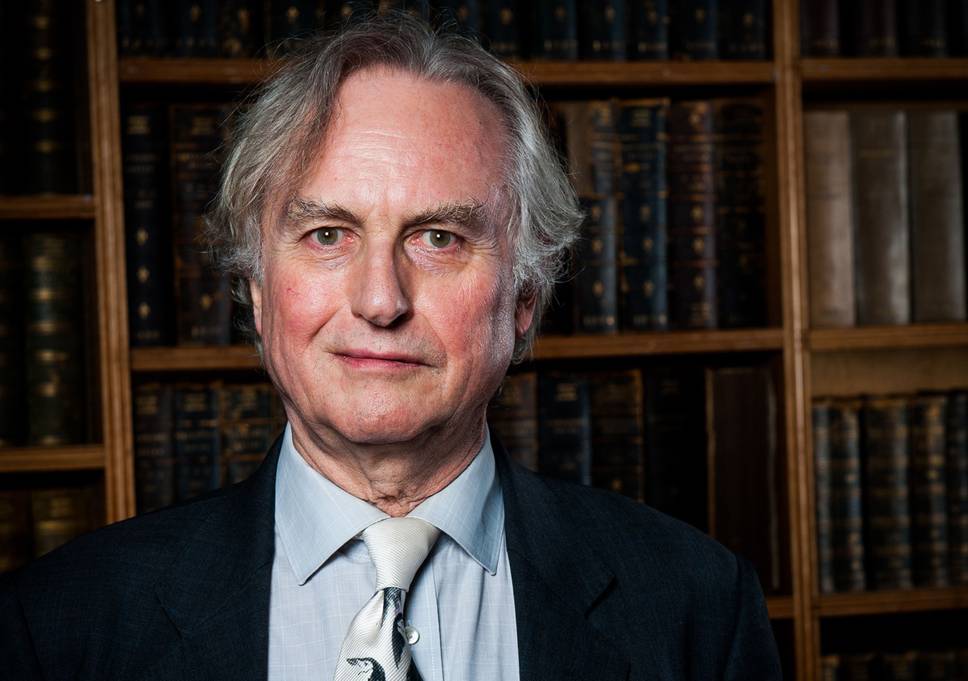

Sin embargo, ¿y si, como parece probable, la mayor maravilla de la ciencia moderna resulta ser la obtención de imágenes cerebrales? ¿Y si, dentro de diez años, las imágenes cerebrales han demostrado, más allá de toda duda posible, que no sólo Edward O. Wilson sino también la joven generación, están en lo cierto? Los patriarcas, como el propio Wilson, Daniel C. Dennett, el autor de DARWIN’S DANGEROUS IDEA: EVOLUTION AND THE MEANINGS OF LIFE y Richard Dawkins, el autor de EL GEN EGOÍSTA y EL RELOJERO CIEGO, insisten en que no hay nada que temer de la verdad, del desarrollo último de la peligrosa idea de Darwin.

Presentan elegantes argumentos de porqué la neurociencia no disminuirá en modo alguno la riqueza de la vida, la magia del arte o la justicia de las causas políticas, incluyendo, si hay que decirlo, la corrección política en Harvard o en Turfs, donde Dennet es director del Centro para los Estudios Cognitivos, o en Oxford, donde Dawkins es algo llamado profesor de Comprensión Pública de la Ciencia. (Dennet, Dawkins, al igual que Wilson, defienden sincera y apasionadamente la corrección política.)

No obstante, a pesar de todos sus esfuerzos, la neurociencia no llega al público en rizadas olas de erudición tranquilizadora. Y el caso es que las olas están creciendo, y con rapidez. La conclusión que sacan quienes no están en los laboratorios es: ¡todo está decidido de antemano!, ¡estamos programados! Y también, ¡no me eches la culpa, estoy mal programado! Este súbito cambio de una creencia en la educación, en forma de condicionamiento social, a una creencia en la naturaleza, en forma de genética y fisiología del cerebro, es el más grande de los acontecimientos intelectuales, para retomar las palabras de Nietzsche, de finales del siglo XX.

Hasta hoy las dos teorías más influyentes del siglo habían sido el marxismo y el freudismo. Ambas se basaban en la premisa de que los seres humanos y sus «ideales» -también Marx y Freud sabían de comillas– se encuentran moldeados por el entorno. Para Marx, el acontecimiento crucial era la propia clase social; los «ideales», las «fes» eran nociones que las clases superiores imbuían a las inferiores como instrumento de control social. Para Freud, el entorno crucial era el drama edípico, la trama sexual inconsciente representada por la familia durante la primera época de la vida del niño.

Los «ideales» y las «fes» que tanto apreciáis son sólo los muebles de la sala de estar en la que recibís a los invitados; os mostraré el sótano, la caldera, las cañerías, el vapor sexual que recorre de verdad la casa. A mediados de los cincuenta, incluso los antimarxistas y los antifreudianos habían llegado a asumir la centralidad de la dominación de clase y las pulsiones sexuales edípicamente condicionadas. Después vinieron Pávlov con sus «vínculos de estímulo-respuesta» y B.F. Skinner con su «condicionamiento operante», y la supremacía del condicionamiento se convirtió en algo que se acercaba a una forma precisa de ingeniería.

¿Qué ha ocurrido, pues, para que esta brillante moda intelectual haya llegado a un final tan chirriante e ignominioso? La defunción del freudismo puede sintetizarse en una única palabra: “litio”. En 1949, un psiquiatra australiano, John Cade, administró durante cinco días –por razones totalmente equivocadas– una terapia de litio a un paciente mental de 51 años tan maníaco-depresivo que llevaba 20 años recluido en centros psiquiátricos. Al sexto día, gracias a la concentración de litio en la sangre era un hombre normal.

Al cabo de tres meses recibió el alta y vivió feliz el resto de su vida en su propia casa. Ese hombre había sido y sometido en vano a dos décadas de logorrea freudiana. A lo largo de los siguientes veinte años, los fármacos antidepresivos y los tranquilizantes substituyeron por completo la palabrería freudiana como tratamiento de los trastornos mentales serios. A mediados de la década de 1980, los neurocientíficos consideraban la psiquiatría freudiana como una pintoresca reliquia basada en gran medida en la superstición (por ejemplo, el análisis de los sueños… ¡el análisis de los sueños!) como la frenología o el mesmerismo.

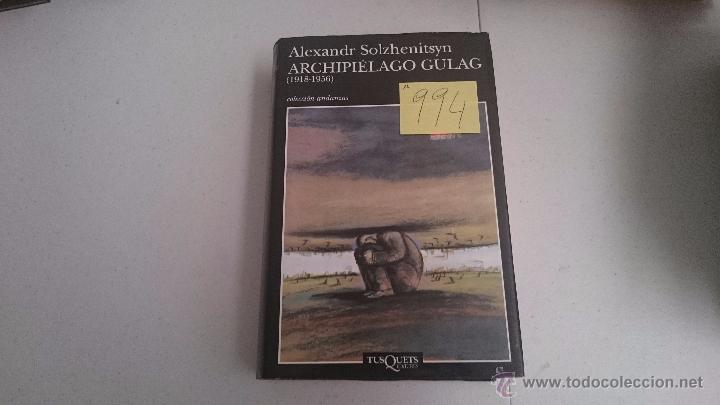

En realidad, entre los neurocientíficos, la frenología goza hoy de una mayor reputación que la psiquiatría freudiana, puesto que fue en un cierto sentido una precursora de la encefalografía. Los psiquiatras freudianos son hoy considerados como carcamales con títulos médicos falsos, como orejas velludas que algunas personas pueden permitirse pagar para hablar en ellas. El marxismo llegó a su conclusión de una manera más abrupta –en un solo año, 1973– con la salida clandestina de la Unión Soviética y la publicación en Francia de los tres volúmenes del ARCHIPIÉLAGO GULAG de Alexandr Solzhenitsin.

Otros escritores, en particular el historiador británico Robert Conquest, ya habían expuesto la vasta red de campos de concentración de la Unión Soviética, pero su obra se basaba en gran medida en el testimonio de refugiados políticos, a quienes se descartaba de modo rutinario porque se consideraban observadores tendenciosos y amargados. En cambio Solzhenitsin era un ciudadano soviético que seguía viviendo en suelo soviético, un «zek» durante once años («zek» es en argot ruso un prisionero de un campo de concentración).

Su credibilidad procedía, nada más y nada menos que del propio Nikita Jruschov, quien en 1962 había permitido la publicación de su novela corta sobre el Gulag, UN DÍA EN LA VIDA DE IVÁN DENISÓVICH, como forma de recortar la intimidante sombra de su predecesor. «Si –había dicho en efecto Jruschov–, lo que este hombre, Solzhenitsin, dice es cierto. Tales fueron los crímenes de Stalin.» Esa breve descripción ficticia del sistema soviético de trabajo en régimen de esclavitud ya fue de por sí bastante perjudicial; pero ARCHIPIÉLAGO GULAG, un relato no ficticio, denso y detallado, de dos mil páginas sobre el sistemático exterminio por parte del PCUS [Partido Comunista de la Unión Soviética] de sus enemigos reales e imaginarios, el exterminio de sus propios conciudadanos, de decenas de millones de personas, por medio de un enorme, metódico y burocrático «sistema de tratamiento de residuos humanos», como lo denominó Solzhenitsin… ARCHIPIÉLAGO GULAG resultó ser devastador.

Al fin y al cabo, éste ha sido un siglo en el que ya no ha habido ninguna evasiva ideológica posible para el campo de concentración. Entre los intelectuales europeos, incluso entre los intelectuales franceses, el marxismo se desplomó inmediatamente como fuerza espiritual. Aunque parezca irónico, sobrevivió más tiempo en Estados Unidos antes de sufrir un piadoso golpe de gracia final el 9 de noviembre de 1989, con el derrumbe del Muro de Berlín, que puso de manifiesto de forma inequívoca el desastre de los setenta y dos años de experimento socialista en la Unión Soviética.

(El marxismo sigue resistiendo, precaria y acrobáticamente, en las universidades estadounidenses bajo una forma manierista conocida como «deconstrucción», una doctrina literaria que describe el lenguaje como una herramienta insidiosa utilizada por el poder para engañar a proletarios y campesinos.) El freudismo y el marxismo –y con ellos la creencia en el condicionamiento social– fueron derruidos de un modo tan rápido y repentino que da la impresión de que la neurociencia se ha alzado en un vacío intelectual. No hace falta ser científico para detectar la desbandada.

Todo el que tenga un hijo en edad escolar conoce perfectamente los síntomas. Tengo hijos en edad escolar y me fascina la fe que otorgan hoy los padres a los psicólogos que diagnostican a sus hijos un defecto conocido como trastorno por déficit de atención (TDA). Por supuesto, no tengo medios para saber si este «trastorno» es o no una dolencia real, física y neurológica, pero tampoco lo sabe nadie en esta etapa temprana de la neurociencia. Los síntomas de esta supuesta enfermedad son siempre los mismos.

Los niños o, más bien, el niño –cuarenta y nueve casos de cada cincuenta son varones– se agita en la escuela, mueve la silla, no presta atención, distrae a sus compañeros durante la clase y tiene un pobre rendimiento escolar. En otra época, se le habría presionado para que prestara atención, se esforzara más, mostrara una mayor autodisciplina. A los padres atrapados en el nuevo clima intelectual de los noventa, este enfoque les parece cruel, porque el problema de mi querido hijo… ¡es que está mal programado! Pobrecito… ¡cuando nació ya estaba todo decidido! De modo invariable los padres se quejan: «Lo único que le interesa es sentarse delante del televisor y mirar los dibujos animados o jugar con los videojuegos.» ¿Durante cuanto tiempo? «¿Durante cuanto tiempo? Durante horas y horas» Durante horas y horas; como cualquier joven neurocientífico explicará, quizá el chico tenga un problema pero, desde luego, no se trata de un trastorno de la atención. No obstante, a lo largo y ancho del país asistimos al espectáculo de toda una generación de niños, decenas de millares, a los que se les administra la solución mágica en boga contra el trastorno por déficit de atención (TDA), Ritalin, el nombre comercial dado por la compañía farmacéutica CIBA al estimulante metilfedinato.

La primera vez que me topé con el Ritalin fue en 1966, cuando me encontraba en San Francisco investigando para un libro sobre el movimiento psicodélico o hippy. Cierta especie del género hippy recibía el nombre de Speed Freak, y cierta variedad de Speed Freak se llamaba Cabeza de Ritalin. A los Cabezas de Ritalin les encantaba el Ritalin. Ni un movimiento, ni un sonido… Se quedaban sentados, absortos en cualquier cosa… una tapa de alcantarilla, las líneas de la palma de la mano… indefinidamente… en lugar de comer… en lugar de dormir… Nirvana de metilfenidato puro… Entre 1990 y 1995, las ventas que CIBA realizó de Ritalin crecieron un 600 por ciento; y no a causa de las apetencias de alguna subvariante de la especie Speed Freak de San Francisco.

Más bien a causa de toda una generación de chavales estadounidenses que, desde las mejores escuelas privadas del Noreste hasta las más cenagosas escuelas públicas de Los Ángeles y San Diego es hoy adicta al metilfenidato que les suministra cada día su contacto, la enfermera de la escuela. Estados Unidos es un país maravilloso. Lo digo en serio. Ningún escritor honesto pondría en duda semejante afirmación. La comedia humana no se queda nunca sin material. Nunca te deja colgado.

Mientras tanto, la noción de un yo –un yo que ejerce la autodisciplina, pospone la gratificación, doblega el apetito sexual, contiene la agresión y el comportamiento criminal–, un yo capaz de volverse más inteligente y alzarse hasta las cumbres de la vida por sus propios medios, gracias al estudio, la práctica, la perseverancia y la negativa a rendirse ante grandes retos… esa anticuada noción del éxito por medio de la iniciativa y la determinación desaparece… desaparece… desaparece… La fe típicamente estadounidense en el poder del individuo para transformarse y pasar de ser un don nadie a gigante entre los hombres, una fe que va de Emerson («Independencia») a las historias de «Luck and Pluck» de Horatio Alger y al «Cómo ganar amigos e influir sobre las personas» de Dale Carnegie, «El poder del pensamiento tenaz» de Norman Vincent Peale y «El vendedor más grande del mundo» de Og Mandino, esa fe se encuentra hoy tan moribunda como el dios de quien Nietzsche escribió el obituario en 1882.

Sobrevive hoy sólo bajo la decrépita forma de la «charla motivacional», como la denominan los agentes de los conferenciantes, dada por estrellas del fútbol retiradas como Frank Tankerton a públicos formados por hombres de negocios, en su mayor parte deportistas frustrados (como el autor de este artículo) acerca de cómo la vida se parece a un partido de fútbol americano. «Estás al final de la cuarta parte, pierdes por trece puntos, y los Cowboys te han arrinconado en tu línea de una yarda y es tu penúltima posesión de la pelota y tienes que hacer veintitrés yardas. ¿Qué haces?…» Lo siento, Fran, pero es tu última posesión de la pelota y tienes que hacer veintitrés yardas y la genética lo tiene todo decidido de antemano y la prensa popular y la televisión bombean el nuevo mensaje a un ritmo vertiginoso.

¿A través de quién? A través de una nueva raza que se llaman a sí mismos «psicólogos humanistas». No cabe duda de que hace veinte años esas mismas personas se habrían llamado a sí mismas «freudianos»; pero hoy son deterministas genéticos, y la prensa muestra un apetito voraz ante cualquier nuevo hallazgo que quieran presentarle. Actualmente el estudio más popular –sigue apareciendo en los programas de televisión meses más tarde– es el realizado por David Likken y Auke Tellegen de la Universidad de Minnesota con dos mil gemelos. Según estos dos psicólogos evolucionistas, el estudio muestra que la felicidad de un individuo es en gran medida genética.

Algunas personas están programadas para ser felices y otras no. El éxito (o el fracaso) en cuestiones de amor, dinero, fama o poder es algo pasajero; no tardamos en bajar (o subir) al nivel de felicidad que tenemos asignado genéticamente. En septiembre de 1996, la revista Fortune dedicó una extensa sección con elaboradas ilustraciones a un estudio realizado por psicólogos evolucionistas de la Universidad de Saint Andrews en el Reino Unido que demostraba que juzgamos la belleza o el atractivo facial de las personas que conocemos no según los estándares sociales de la época en que vivimos sino según criterios estampados en nuestro cerebro desde el nacimiento.

O, para decirlo de otro modo, la belleza no está en el ojo del que mira sino encastada en sus genes. En realidad, hoy a finales de 1996, a apenas tres años del final del milenio, si uno goza del suficiente apetito para seguir los periódicos, las revistas y la televisión, no tarda en tener la impresión de que no hay nada en la vida, incluyendo la cantidad de grasa del cuerpo, que no esté genéticamente predeterminado. Mencionaré sólo unas pocas cosas en las que los psicólogos evolucionistas me han iluminado en los últimos dos meses. El macho de la especie humana está genéticamente programado para ser polígamo, es decir, infiel a su pareja legal. Cualquier varón lector de revistas comprende enseguida la idea.

(¡La culpa la tienen los tres millones de años de evolución!) Las mujeres se sienten atraídas por las celebridades porque están genéticamente programadas para percibir que los machos alfa son capaces de cuidar mejor a su descendencia. (Sólo soy una vigilante de la reserva genética, cariño). Las adolescentes están programadas genéticamente para ser promiscuas y son tan incapaces de contenerse como los perros de un parque. (La escuela proporciona los preservativos). La mayoría de los asesinatos son resultado de compulsiones genéticamente programadas.

(Los convictos también leen y luego dicen a los psiquiatras penitenciarios cosas como «Algo se apoderó de mí… y entonces el cuchillo salió disparado») [2] ¿Dónde queda a todo esto el autocontrol? ¿Dónde queda si la gente no cree, y así lo demuestran de una vez por todas las imágenes cerebrales, en ningún yo fantasmal? Hasta ahora, la teoría neurocientífica se basa en gran medida en pruebas indirectas, en estudios con animales o en los cambios que se producen en el cerebro humano normal cuando éste sufre alguna alteración (por accidentes, enfermedades, cirugía radical o punciones experimentales).

El propio Darwin II, Edward O. Wilson, posee sólo un limitado conocimiento directo del cerebro humano. Es zoólogo, no neurólogo, y sus teorías son extrapolaciones de la exhaustiva labor que ha llevado a cabo en su especialidad, el estudio de los insectos. El cirujano francés Paul Broca descubrió el área de Broca, uno de los dos centros del habla del hemisferio izquierdo del cerebro, como consecuencia del derrame cerebral padecido por uno de sus pacientes.

Incluso la TEP y la TEP identificadora de genes/TEP identificadora de marcadores son, en términos técnicos, prácticas médicas invasoras, puesto que hacen necesaria la inyección de substancias químicas o virus en el cuerpo. Sin embargo, nos permiten vislumbrar cómo es probable que sean en el futuro las técnicas no invasivas de obtención de imágenes. Un neuroradiólogo lee en voz alta una lista de temas a una persona sometida a una TEP; temas relacionados con los deportes, la música, los negocios, la historia, cualquier cosa, y, cuando por fin hay uno que le interesa a la persona, en la pantalla se enciende un área determinada del córtex cerebral.

Con el tiempo, a medida que se refinen las técnicas, la imagen resultante será tan clara y completa como las que muestran, en las ferias de automóviles, el funcionamiento de un motor de combustión interna. En este punto, a todo el mundo le resultará evidente que lo que contempla es sólo una maquinaria, un ordenador químico analógico, que procesa la información del entorno. «Sólo», puesto que por más que miremos no encontraremos dentro ningún yo fantasmal, ni mente ni alma algunas.

De modo que, en el año 2006 o en 2026, algún nuevo Nietzsche dará otro paso más y anunciará: «El yo ha muerto», salvo que, dada –como en el caso de Nietzsche– su tendencia a la poesía, lo más probable es que diga: «El alma ha muerto». Dirá que sólo se limita a dar la noticia, la noticia del más grande acontecimiento del milenio: «El alma, ese último refugio de los valores, ha muerto, porque las personas cultas ya no creen que exista».

Si las garantías de seguridad de los Wilsons, los Dennetts y los Dawkins no empiezan también a crecer, el terrible carnaval que tendrá lugar hará palidecer la expresión «el eclipse total de los valores». Si fuera estudiante universitario, no creo que pudiera resistirme a la tentación de dedicarme a la neurociencia. Ahí encontramos los dos enigmas más fascinantes del siglo XXI: el enigma de la mente humana y el enigma de lo que ocurre cuando la mente humana llega a conocerse de modo absoluto.

En cualquier caso, vivimos en una época en que es imposible e inútil apartar los ojos de la verdad. De modo irónico, dijo Nietzsche, esa inflexible disposición para la verdad, esa pasión por el escepticismo, es el legado del cristianismo (por complicadas razones que no deben detenernos ahora). Y añadió una muestra última y quizá suprema de ironía en un pasaje fragmentario contenido en un cuaderno que escribió poco antes de enloquecer (como consecuencia del gran flagelo venéreo del siglo XIX, la sífilis).

Predijo que la ciencia moderna acabaría dirigiendo la imparable fuerza de escepticismo contra sí misma, pondría en cuestión la validez de sus propios cimientos, los derribaría y se autodestruiría. Me acordé de eso durante el verano de 1994 durante el verano de 1994, cuando un grupo de matemáticos y especialistas en computación celebró un congreso en el Instituto de Santa Fe sobre «Los límites del conocimiento».

La idea de base era que la mente humana, al ser en el fondo un aparato completamente físico, una forma de ordenador, el producto de una historia genética particular, resulta finita en sus capacidades. Al ser finita, al estar programada, es probable que nunca sea capaz de aprehender la existencia humana de un modo completo. Sería como si un grupo de perros organizara un congreso para intentar comprender «el Perro». Por mucho que se esforzaran, no llegarían demasiado lejos. Los perros sólo pueden comunicar una cuarentena de nociones, todas ellas primitivas, y no pueden registrar nada.

El proyecto estaría condenado desde el principio. El cerebro humano es con mucho superior al perro, pero sigue siendo limitado. Por ello, cualquier esperanza, por parte de los seres humanos, de llegar a una teoría final, completa y autónoma de la existencia humana también está condenada al fracaso. Ésta visión, el Escepticismo Supremo de la ciencia, se ha ido difundiendo desde entonces. Desde hace dos años, incluso el darwinismo, el principio sagrado de los científicos estadounidenses a lo largo de los últimos setenta años no ha dejado de sufrir los embates de… las dudas.

Los científicos –no los fanáticos religiosos–, en especial el matemático David Berlinski («The Deniable Darwin» – en Commentary, junio de 1996) y el bioquímico Michael Behe (DARWIN’S BLACK BOX, 1996), han empezado a atacar el darwinismo tachándolo de simple teoría, no un descubrimiento científico, una teoría que, lamentablemente, las pruebas fósiles no respaldan y que presenta auténticas majaderías en el núcleo de su lógica. Ya se oyen los gritos de Dennett y Dawkins, para quienes Darwin es el Unigénito.

Están fuera de sí, al borde del ataque. Wilson, el gigante, mantiene la calma y permanece por encima del estrépito). En 1990, el físico Petr Beckmann de la Universidad de Colorado había empezado a ir a por Einstein. Sentía una enorme admiración por su famosa ecuación de la energía y la materia, E=mc2, pero dijo que la teoría de la relatividad era en gran parte absurda y grotescamente incomprobable. Beckmann murió en 1993.

Su testigo fue retomado por Howard Hayden de la Universidad de Connecticut, que cuenta con muchos admiradores entre la joven generación de físicos supremamente escépticos. El menosprecio que la joven generación dedica a la mecánica cuántica («no tiene aplicaciones en el mundo real», «todo son hadas que te espolvorean en la cara ecuaciones somníferas»), la teoría del campo unitario («un señuelo para el Nobel») y la teoría de la Gran Explosión («creacionismo para genios») se ha vuelto corrosivo. ¡Ojalá Nietzsche estuviera vivo! ¡Lo que habría disfrutado!

Hace poco, estuve conversando con una destacada geóloga californiana y me dijo: «Cuando empecé a dedicarme a la geología, todos creíamos que, en ciencia, lo que se hace es crear una sólida base de hallazgos por medio del experimento y la investigación minuciosa a la que luego se añade una segunda capa, como una segunda capa de ladrillos, todo con mucho cuidado, y así sucesivamente. Al final, algún científico arriesgado apila los ladrillos en torres, pero las torres resultan ser poco sólidas y se derrumban, y entonces empiezas otra vez a colocar capas con cuidado. Sin embargo, nos hemos dado cuenta de que las primeras capas no descansan en absoluto sobre suelo firme. Se mantienen en equilibrio encima de burbujas, en conceptos que están llenos de aire, y ahora las burbujas empiezan a estallar, una tras otra.»

De pronto, tuve una visión del sorprendente edificio derrumbándose y del hombre moderno precipitándose de nuevo en el lodo primordial. Lucha, chapotea, busca aire, se agita frenéticamente en el lodo; entonces siente que algo enorme y suave nada detrás de él y lo levanta, como si fuera un delfín todopoderoso. No puede verlo pero su sorpresa es mayúscula. Decide llamarlo Dios.

[1] La palabra «neurométrico» se identifica con E. Roy John, que ha ideado la «batería neurométrica», un sistema para analizar las funciones cerebrales y el «analizador neurométrico», un instrumento patentado que se utiliza con la batería; sin embargo, John no tiene ninguna relación con Neurometrics Inc. La batería la describe en NEUROMETRIC www.alcoberro.info EVALUATION OF BAIN FUNCTION IN NORMAL AND LEARNING DISABLED CHILDREN, Ann Arbor: University of Michigan Press, 1989. [2] Contado por Theodore Darlymple, psiquiatra penitenciario británico, en la revista CITY JOURNAL. © Tom Wolfe, 1996 © Por la traducción: Juan Gabriel López Guix